2016년 알파고의 등장으로 ‘인공지능’이라는 개념이 우리 일상 곁에 훨씬 가까이 다가왔다. 이 기술은 구글의 나우와 같은 개인 비서부터 자율주행자동차, 의료, 교통, 물류, 안전, 환경 거의 모든 분야에서 빠르게 확산되고 있다. 또한 차세대 지식정보 사회를 이끌어 갈 새로운 부가가치 창출 분야로 주목받고 있기도 하다. 하지만 긍정적 측면만 있는 것은 아니다. 인공지능 기술이 가져올 부정적 효과도 만만치 않다. 새로운 연재를 통해 인공지능 기술이 우리사회 전반에 미치는 영향에 관해 알아보는 그 두 번째로 인공지능의 역사에 대해 알아본다. (편집자 주) (위 사진: 1938년 Alvin Lodge(Millersville, PA)가 원격 제어 잔디 깍는 기계를 개발했다. 100 피트 떨어진 거리에서 케이블 가이드를 따라 성공적 작동했다는 기사. (Source: Mechanix Illustrated, Oct, 1938)

인공지능(AI, Artificial Intelligence)은 어떻게 시작이 되었을까? 1956년 미국 다트머스 대학 존 매카시(John McCarthy )교수가 개최한 다트머스회의에서 처음으로 인공지능(AI)라는 용어가 사용되기 시작했는데 당시 인공지능 연구의 핵심은 추론과 탐색 수준이었다.

이후 오늘날 인공지능처럼 각광을 받는 계기가 된 것이 인터넷의 출현과 발전이다. 인터넷으로 중흥기를 맞게 되는데 검색 엔진 등을 통해 그 전과는 비교도 할 수도 없는 방대한 데이터를 수집할 수 있어 머신러닝(Machine Learning)이 가능해진 것이다. 수많은 빅데이터의 수집과 분석을 통해 본격 인공지능 시스템으로 진화하고 그 결과로 인간을 이기는 알파고가 등장한 것이다. 또한 인간의 뇌를 모방한 신경망 네트워크(neural networks) 구조로 이루어진 딥러닝 알고리즘은 기존 머신러닝의 한계를 더욱 뛰어넘게 했다.

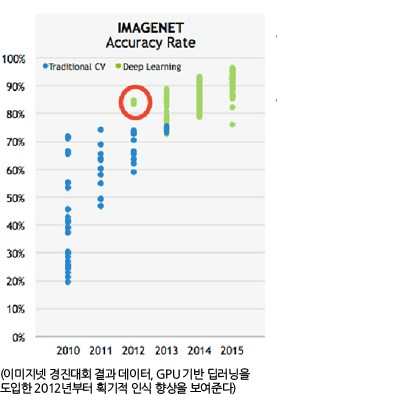

2006년 캐나다 토론토대학의 제프리 힌튼 교수가 처음 발표하면서 알려지게 된 딥러닝은 얀 레쿤과 앤드류 응과 같은 세계적인 딥러닝 구루들에 의해 더욱 발전했고 현재 이들은 구글, 페이스북, 바이두 같은 글로벌 IT 회사에 영입되어 그 연구를 더욱 가속화가고 있다. 주로 음성 인식, 영상 이해, 기계 번역 등에 쓰이고 있는 딥러닝 알고리즘은 2012년 캐나다 토론토대학의 알렉스 크리제브스키가 이미지넷(IMAGENET)이라 불리는 이미지 인식 경진 대회에서 딥러닝을 활용하여 자체적으로 이미지를 인식하는 컴퓨터로 우승을 차지하면서 또 한번의 획기적인 전환점을 맞이하게 된다. 딥러닝 연구에 그래픽 처리 장치(GPU)가 전면으로 등장하게 된 계기이다.(‘인공지능(AI)은 어떻게 발달해왔는가, 인공지능의 역사’ kor_nvidia 발췌)

본래 상당수 인공지능 연구 목적은 심리학에 대한 실험적인 접근이었고 언어 지능(linguistic intelligence)이 무엇인지를 밝혀내는 것이 주 목표였다.(튜링 테스트가 대표적 예) 인공지능 학자는 동물들은 인간들보다 모방하기 쉽다고 주장한다. 그러나 동물의 지능을 만족하는 계산 모델은 없다. 이런 배경으로 위키피디아의 인공지능의 역사를 인용해 알아보자.

1. 인공지능의 탄생(1952~1956년)

1940년대 후반과 1950년대 초반에 이르러서 수학, 철학, 공학, 경제 등 다양한 영역의 과학자들에게서 인공적인 두뇌의 가능성이 논의되었다. 1956년에는 인공지능이 학문 분야로 본격 들어선다.

인공두뇌학과 초기 신경 네트워크, 즉 생각하는 기계에 대한 초기 연구는 30년대 후기에서부터 50년대 초기의 유행한 아이디어에 영감을 얻은 것이었다. 당시 신경학의 최신 연구는 실제 뇌가 뉴런으로 이루어진 전기적인 네트워크라고 보았다. 위너가 인공두뇌학을 전기적 네트워크의 제어와 안정화로 묘사했으며 섀넌의 정보 과학은 디지털 신호로 묘사했다. 또 튜링의 계산 이론은 어떤 형태의 계산도 디지털로 나타낼 수 있음을 보였다. 이런 여러 밀접한 연관에서, 인공두뇌의 전자적 구축에 대한 아이디어가 나온 것이다.

월터 피츠(Walter Pitts)와 워런 매컬러(Warren Sturgis McCulloch)는 인공 신경망에 기인한 네트워크를 분석하고 그들이 어떻게 간단한 논리적 기능을 하는지 보여주었다. 그들은 후에 신경 네트워크라 부르는 기술을 첫 번째로 연구한 사람이다. 피츠와 매컬러는 24살의 대학원생인 젊은 마빈 민스키를 만났고, 민스키는 1951년 첫번째 신경 네트워크 기계인 SNARC를 구축했다. 민스키는 향후 50년동안 인공지능의 가장 중요한 지도적, 혁신적 인물 중 하나가 되었다.

1950년 앨런 튜링은 생각하는 기계의 구현 가능성에 대한 분석이 담긴, 인공지능 역사에서 혁혁한 논문을 발표했다. 그는 ‘생각’을 정의하기 어려움에 주목해 그 유명한 튜링테스트를 고안했다. 텔레프린터를 통한 대화에서 기계가 사람인지 기계인지 구별할 수 없을 정도로 대화를 잘 이끌어 간다면 이것은 기계가 ‘생각’하고 있다고 말할 충분한 근거가 된다는 것이었다. 튜링 테스트는 인공 지능에 대한 최초의 심도 깊은 철학적 제안이다.

1951년에 맨체스터 대학의 페란티 마크 1(Ferranti Mark 1) 기계를 사용해, 크리스토퍼 스트레이(Christopher Strachey)는 체커 프로그램을 작성했고 디트리히 프린츠(Dietrich Prinz)는 체스 프로그램을 작성했다. 아서 새뮤얼(Arthur Samuel)이 50년대 중반과 60년대 초반에 개발한 체커 프로그램은 결국 존경받는 아마추어에 도전할 수 있는 충분한 기술적 발전을 이룩했다.

디지털 컴퓨터가 개발된 50년대 중반에 이르러서 몇몇 과학자들은 직관적으로 기계가 수를 다루듯 기호를 다루고, 사람처럼 기호의 본질적인 부분'까지 다룰 수 있을 것이라고 생각했다. 이것은 생각하는 기계를 만드는 새로운 접근 방법이었다. 1995년에, 앨런 뉴얼(Allen Newell)과 허버트 사이먼(Herbert A. Simon)은 ‘논리 이론’을 구현했다. 그 프로그램은 결국 러셀과 화이트헤드의 '수학 원리'에 나오는 52개의 정리 중 32개를 증명해냈고 일부 새롭고 더 우아한 증거를 찾아내기도 했다.

1956년에 열린 다트머스 컨퍼런스는 마빈 민스키와 존 매카시, 그리고 IBM의 수석 과학자인 클로드 섀넌과 네이선 로체스터(Nathan Rochester)가 개최했다. 컨퍼런스는 "학습의 모든 면 또는 지능의 다른 모든 특성로 기계를 정밀하게 기술할 수 있고 이를 시물레이션 할 수 있다"라는 주장을 포함하여 제안을 제기했다. 참가자는 레이 솔로모노프(Ray Solomonoff), 올리버 셀프리지(Oliver Selfridge), 트렌처드 모어(Trenchard More), 아서 새뮤얼(Arthur Smuel), 앨런 뉴얼(Allen Newell)과 허버트 사이먼(Herbert A. Simon)으로 그들 모두 수십년동안 인공지능 연구에서 중요한 프로그램을 만들어온 사람들이었다. 컨퍼런스에서 뉴얼과 사이먼은 ‘논리 이론’을 소개했고 매카시는 Artificial Intelligence를 그들의 연구를 칭하는 이름으로 받아들이길 설득했다. 1956년 다트머스 컨퍼런스는 AI 라는 이름, 목표점, 첫 번째 성공과 이를 이룬 사람들, 그리고 넓은 의미의 AI가 탄생하는 순간이었다.

2. 황금기(1956~1974년)

다트머스 컨퍼런스 이후 AI라는 새로운 영역은 가속적으로 발전한다. 이 기간에 만들어진 프로그램은 많은 사람들을 놀라게(astonishing) 했는데 프로그램은 대수학 문제를 풀었고 기하학의 정리를 증명했으며 영어를 학습했다. 몇몇 사람들은 이와 같은 기계의 ‘지능적’ 행동을 보고 AI로 모든 것이 가능할 것이라 믿었다.

연구자들은 개인의 의견 또는 출판물들을 통해 낙관론을 펼쳤고 완벽한 지능을 갖춘 기계가 20년 안에 탄생할 것이라고 예측했다. 50년대 후반과 60년대에 많은 성공적 프로그램과 새로운 발전 방향이 나타났다. 초기 AI 프로그램은 동일한 기본적인 알고리즘을 사용했다. 게임의 승리나 정리 증명 같은 어떤 목표 달성을 위해 그들은 한 발짝씩 나아가는(step-by-step) 방식을 택했다. 예를 들어 미로를 찾아갈 때 계속 나아가면서 막힌 길이 있으면 다른 길이 있는 곳까지 되돌아 왔다가 다른 길로 수정해 가는 식이었다. 이런 패러다임을 ‘탐색 추리’라 불렸다. 주요한 문제는 간단한 미로에 있어서도 경로로 사용할 수 있는 수가 천문학적으로 많았다는 것이다. 연구자들은 추론 또는 경험적으로 찾은 규칙으로 정답이 아닌듯 보이는 경로를 지우는 방식을 사용했다.

AI 연구의 또 다른 목표는 영어와 같은 자연어로 컴퓨터와 의사 소통할 수 있게 하는 것이었다. 일찍이 다니엘 보로우(Daniel Bobrow)의 ‘STUDENT’라는 프로그램은 고등학교 수준의 대수학 단어 문제를 푸는데 성공했다. 조셉 웨이젠바움(Joseph Weizenbaum)의 ELIZA는 대화를 나누는 때때로 상대가 컴퓨터가 아니라 사람이라고 생각할 정도의 수준을 보여 주었다. 사실 ELIZA는 스스로 생각하여 말하지 않았고 프로그램은 오직 판에 박힌 말을 하거나, 상대에게 방금 말한 말을 다시 해달라고 요청하거나, 상대가 한 말을 몇 개의 문법 법칙에 의해 파싱(parsing, 컴퓨터가 문장 단위의 문자열을 토큰(token)으로 분류하고 이를 구문 트리(parse tree)로 재구성하는 구문 분석 과정)할 뿐이었다. ELIZA는 첫 번째 채팅 프로그램이었다.

1960년대 후반, MIT의 AI 연구소 마빈 민스키와 시모어 페퍼트는 마이크로월드 연구라고 불리는 인위적인 간단한 상황에 초점을 맞춘 AI 연구를 제안했다. 그들은 성공적인 과학자들이 자주 쉬운 이해를 위해 '마찰면'이라든지 '강체(물리학에서 결코 형태가 변하지 않는 물체)'같은 간단한 모델을 사용한다는 것에 집중했다. 이런 연구의 대부분이 평평한 평면 위의 다양한 형태와 색깔의 블록으로 이루어진 '블록 단위의 세계'에 초점을 맞추는 형식이었다. 제라드 서스먼(Gerald Sussman)을 필두로 아돌프 구즈먼(Adolfo Guzman), 다비드 왈츠(David Waltz) 그리고 패트릭 윈스턴(Patrick Winston)이 마이크로월드 패러다임으로 기계 비전의 혁신을 이끌었다. 같은 시간에, 민스키와 페퍼는 블록을 쌓을 수 있는 로봇 팔을 제작했다. 마이크로월드의 영광스러운 성취는 테리 위노가드(Terry Winograd)의 SHRDLU이며 이것은 보통의 일반 문장으로 소통해 작업을 계획하고 이를 실행할 수 있었다.

AI 연구의 일세대들은 그들의 연구 결과에 대해 다음과 같이 예측했다.

사이먼(H. A. Simon)과 뉴얼(Allen Newell) : "10년 내에 디지털 컴퓨터가 체스 세계 챔피언을 이길 것이다", 덧붙여 "10년 내에 디지털 컴퓨터는 중요한 새로운 수학적 정리를 발견하고 증명할 것이다"(1958년)

사이먼 : "20년 내에 기계가 사람이 할 수 있는 모든 일을 할 것이다."(1965년)

마빈 민스키 : "이번 세기에 AI를 만드는 문제는 거의 해결 될 것이다.(1967년)

마빈 민스키 : "3~8년안에 우리를 평균 정도의 인간 지능을 가지는 기계를 가지게 될 것이다. (Life 잡지를 통해서, 1970년)

3. AI의 첫 번째 암흑기(1974~1980년)

70년대에 이르자 AI는 비판의 대상이 되었고 재정적 위기가 닥쳤다. AI 연구가들은 그들의 눈앞에 있는 복잡한 문제를 해결하는데 실패했다. 연구자들의 엄청난 낙관론은 연구에 대한 기대를 매우 높여놓았고 그들이 약속했던 결과를 보여주지 못하자 AI에 대한 투자는 사라져버렸다. 동시에 Connectionism 또는 뉴럴망은 지난 10년동안 마빈 민스키의 퍼셈트론(시각과 뇌의 기능을 모델화한 학습 기계)에 대한 강한 비판에 의해 완전히 중지되었다. 그러나 70년대 후반의 AI에 대한 좋지 않은 대중의 인식에도 불구하고 논리 프로그래밍, 상징 추론과 많은 여러 영역에서의 새로운 아이디어가 나타났다.

70년대초 AI 프로그램의 가능성은 제한적이었다. 모든 문제에 걸쳐서 문제를 푸는 인상 깊은 작품들은 겨우 시험용 버전 정도였고 어떤 의미에선 '장난감'에 가까웠다. AI 연구는 70년대에 더 이상 극복할 수 없는 몇 개의 근본적인 한계에 봉착한다. 몇 개는 오늘날까지도 남아있다.

몇몇 철학자들은 AI 연구자들에게 강력한 반대를 표했다. 초기 반대자들 중 존 루카스(John Lucas)는 괴델의 불완선성의 원리에 의해 컴퓨터 프로그램같은 시스템이 정확하게 사람과 같이 행할 수 없다고 주장한 사람이다. 휴버트 드레이퓨즈(Hubert Dreyfus)는 60년대의 깨어진 약속을 조롱했고 AI의 가설을 비판했으며 인간의 추론이 실제적으론 ‘상징적 진행’이 매우 적게 포함되어 있고 구현적, 본능적, 무의식적인 노하우에 의해 처리된다고 주장했다.

4. Boom (1980~1987년)

1980년대에는 전 세계적으로 사용 된 ‘전문가 시스템’이라고 일컫는 인공지능의 형태였고 인공지능 검색에 초점이 맞춰졌다. 같은 시기에 일본 정부는 자신들의 5세대 컴퓨터 프로젝트와 인공지능에 적극적으로 투자했다. 1980년대에 존 홉필드와 데이비드 루멜하트의 신경망 이론의 복원 이라는 또 다른 사건이 있었다.

전문가 시스템은 특정 지식의 범위에 대해 문제를 해결해주거나 질문에 대답해주는 프로그램이며 전문가의 지식에서 파생 된 논리적 법칙을 사용했다. 최초의 실험은 1965년 Edward Feigenbaum과 그의 제자 Dendral이 시작해 분광계로부터 화합물을 식별하는 실험이었다. MYCIN은 1972년에 개발되었고 전염되는 혈액 질환을 진단하였다. 이러한 접근법(실험)은 타당성이 입증 되었다.

1980년, XCON이라 불리는 전문가 시스템은 디지털 장비 회사인 CMU에서 완성되었다. 이 시스템은 매년 4천만 달러를 절약시켜주며 매우 큰 성과를 나타냈다. 전 세계의 회사들은 1985년에 1억 달러 이상을 AI에 사용해 이를 개발하고 전문가 시스템을 배포하였다. Symbolics, Lisp Machines과 같은 하드웨어 회사와 IntelliCorp, Aion 등의 소프트웨어 회사들이 이를 지원하면서 같이 성장하였다.

전문가 시스템은 특정 지식의 범위에 대해 문제를 해결해주거나 질문에 대답해주는 프로그램이며 전문가의 지식에서 파생 된 논리적 법칙을 사용했다. 최초의 실험은 1965년 Edward Feigenbaum과 그의 제자 Dendral이 시작해 분광계로부터 화합물을 식별하는 실험이었다. MYCIN은 1972년에 개발되었고 전염되는 혈액 질환을 진단하였다. 이러한 접근법(실험)은 타당성이 입증 되었다.

1982년 물리학자 John Hopfield는 (현재 ‘Hopfield net’이라고 불리는) 완벽한 새로운 길에서 정보를 프로세스하고 배울 수 있는 신경망의 형태를 증명해냈다. 이 시기에 David Rumelhart는 (Paul Werbos에 의해 발견된) “backpropagation”이라고 불리는 신경망을 개선하기 위한 새로운 방법을 알리고 있었다. 이러한 두 가지 발견은 1970년 이후 버려진 신경망 이론이라는 분야를 복구시켰다. 새로운 분야는 1986년 분산 병렬처리의 형태로부터 영감을 받았고 이와 같은 형태로 통일되었다. 2권 분량의 논문 집합은 Rumelhart와 물리학자인 James McClelland에 의해 편집되었다. 신경망은 1990년대에 광학 문자 인식 및 음성 인식과 같은 프로그램의 구동 엔진으로 사용되며 상업적으로 성공했다.

5. Bust: the second AI winter (1987~1993년)

1980년대 AI와 비즈니스 커뮤니티의 매력은 상실했고 경제 거품이라는 고전적 형태에 빠졌다. 로봇 공학 분야 연구원인 Rodney Brooks 와 Hans Moravec는 인공지능에 대한 완전히 새로운 접근 방식을 주장했다.

1974년에 전문가 시스템에 대한 열정이 통제할 수 없을 정도로 퍼져나가고 이에 대한 실망이 확실히 따라올 것이라는 걱정이 있었고 이때 ‘AI winter’라는 단어는 만들어졌다. 그들의 두려움은 AI에 대해 일련의 재정적 차질이 있었던 1980년 말에서 1990년대 초반에 잘 나타난다. 이 AI winter 기간의 첫 번째 사건은 1987년에 특성화된 AI 하드웨어 시장이 갑자기 무너진 것이다.

1987년에 애플이나 IBM의 데스크탑 컴퓨터들은 급격히 스피디해지고 성능도 좋아졌다. 또한 Symblics과 기타 회사들이 만든 데스크탑 컴퓨터가 더 비싼 Lisp 기기들보다도 더 좋은 성능을 나타냈다. 즉 더 이상 Lisp 기기들을 살 이유가 사라진 것이다. 결국 최초의 성공한 전문가 시스템인 XCON은 유지하기에 너무 비싸다는 것이 증명되었다. 업데이트하기에도 너무 어려웠고 학습도 되지 않았다. 또한 일반적이지 않은 질문을 했을 때 괴상한 행동을 하는 일명 ‘brittle’이었고 그들은 일찍이 발견된 이러한 문제들에 의해 결국 희생되었다. 전문가 시스템은 특별한 경우에서만 유용할 뿐이었다.

1980년대 후반 몇몇 연구원들이 로봇 공학을 기반으로 한 완전히 새로운 접근법을 제시했다. 그들은 실제 지능을 보여주려면 기계 또한 세상을 인식하고, 이동하고, 살아남고 거래할 줄 알아야 할 필요가 있다고 주장한다. 이들은 이런 감각 운동 기술은 상식적인 추론과 같은 더 높은 단계의 기술이 필요하다고 말했고 실제로 추상적인 추론은 인간의 가장 흥미롭거나 중요한 기술이었다. 이들은 인공지능을 처음부터 다시 시작해야 한다고 주장했다.

1990년에 Elephants Don't Play Chess 논문에서 로봇 공학 연구자인 Rodney Brooks는 직접적으로 물리적 심볼 시스템 가설에 초점을 맞추었고 심볼들은 항상 필요한 것은 아니라고 말한다. “세계는 그 자체만으로 가장 훌륭한 모델이다. 이것은 항상 최신이며 모든 세부사항이 존재한다. 비결은 적절히 그리고 충분히 자주 감지하는 것이다. 80년대와 90년대에 많은 cognitive 과학자들은 또한 사고방식의 심볼 처리 모델을 거절하고 추론에 몸통은 필수적이라고 말했고 이러한 이론을 ‘embodied mind’ 이론이라고 불렀다.

6. 1993년~ 이후

지난 반세기보다 이 시기 AI의 분야는 마침내 가장 오래된 목표 중 몇 가지를 달성한다. 이것은 비록 주가 아닌 보조적 역할들이었지만 산업분야에서 성공적으로 사용되었다. 몇몇 성공은 컴퓨터 성능이 높아졌기 때문이고 또 다른 몇 가지는 고착적인 문제들에 집중해 해결해 나갔기 때문이다.

이러한 성공은 혁신적인 새로운 패러다임 때문이 아니라 복잡한 엔지니어 스킬과 매우 뛰어난 성능을 가진 슈퍼컴퓨터에서 비롯된 것이었다. 실제로 Deep Blue의 컴퓨터는 1951년 Christopher가 체스 하는 법을 가르친 마크 1보다 1천만 배 빨랐다. 이 엄청난 증가는 무어의 법칙에 의해 측정 되는데 이것은 2년마다 컴퓨터의 메모리 속도와 양은 두 배씩 늘어난다는 이론이다. 최초 컴퓨터 성능의 근본적인 문제는 느리지만 서서히 극복되고 있었다.

1990년대에는 ‘지능형 에이전트’라고 불리는 새로운 패러다임이 다 방면에서 수용되고 있었다. 비록 이전의 연구자들은 'divide and conquer' 모듈러를 제안하고 AI에 접근하였지만지능형 에이전트는 Judea Pearl, Allen Newell 등 다른 이들이 AI를 연구하는데 있어서 결정론과 경제성이라는 개념을 가져오기 전까지 현대식 형태를 갖추지 못했다. 경제학자들의 합리적 에이전트라는 정의와 컴퓨터 과학자들의 객체 혹은 모듈러 정의가 합쳐졌을 때 지능형 에이전트의 패러다임이 완성되었다.

지능형 에이전트 시스템은 환경을 인식하고 성공을 가장 극대화 할 수 있는 행동을 취한다. 이러한 정의에 의하면 인간과 인간들의 조직처럼, 예를 들어 회사처럼 특정 문제를 해결하는 간단한 프로그램들을 지능형 에이전트라고 한다. 지능형 에이전트는 AI 연구자들을 ‘the study of intelligent agents’로 정의한다. 이것은 AI의 정의의 일부를 일반화 한 것이다. 이것은 인간의 지능을 넘어 모든 종류의 지능의 연구를 추구한다.

이러한 패러다임은 당시 연구자들에게 고립 문제들에 대해 연구하고 다양하고 유용한 해결법을 찾는 것을 가능하게 했다. 또한 서로서로 문제들과 그것들에 대한 해결책을 공통의 언어로 표현하였고 추상적 에이전트를 사용한 경제학이나 제어 이론등과 같은 다른 개념에도 사용되었다.

AI 연구자들은 과거에 사용했던 것보다 더욱 정교한 수학적 도구를 사용해 개발하기 시작했다. 해결에 AI가 필요한 수많은 문제들이 존재하고 있다는 인식은 수학, 경제학 또는 오퍼레이션 연구 등의 분야에서 이미 연구자들이 AI를 사용하여 실현하고 있었다. 공유된 수학적 언어는 높은 수준의 협력, 좋은 평판, 여러 분야를 성공적으로 이끌고 측정과 증명이 된 결과들의 성취를 가능하게 하였다. AI는 보다 엄격한 과학 학문이 되었다.

1990년대 AI 분야의 많은 연구자들이 일부러 그들의 업무를 다른 이름으로 불렀다. 일부분에서는 이러한 현상은 그들이 그들의 분야가 AI와 근본적으로 다르다고 여겼기 때문이거나 또는 새로운 이름이 투자받기 쉬웠기 때문일 것이라고 한다. 적어도 상업 분야에서는 연구자들에 대해 AI winter에 있었던 실패했던 계약이 꼬리표처럼 따라다녔고 2005년에 뉴욕 타임즈는 “컴퓨터과학과 소프트웨어 엔지니어들은 광기에 쌓인 몽상가처럼 보여지는 두려움 때문에 인공 지능이란 용어를 피했다.” 라고 소개했다.

1968년 Arthur C. Clarke와 Stanely Kubrick은 2001년에는 기계가 인간과 유사하거나 또는 인간의 용량을 뛰어넘는 지능을 가진 존재가 되었을 것이라고 상상했다. 그들이 만든 ‘HAL 9000’이라는 캐릭터는 2001년에 이러한 기계가 존재할 거라고 믿는 많은 AI 연구자들의 공유된 믿음을 기반으로 만들어졌다. Marvin Minsky는 “그래서 왜 우린 2001년에 HAL을 얻지 못했나?”라는 질문을 했다. 대부분의 연구자들이 신경망이나 유전자 알고리즘의 상업적 용도의 프로그램을 추구 했던 반면 Minsky는 해답이 방치된 상식 추론과 같이 매우 중심적인 문제에 있다고 믿었다. 반면에 John McCarthy는 여전히 자격문제를 비난하였다. Ray Kurzweil은 문제는 컴퓨터 성능에 있으며 무어의 법칙을 사용하였을 때 인간 수준의 지능을 가진 기계는 약 2029년에나 나올 것이라고 예견했다. Jeff Hawkins는 신경망 연구자들이 대뇌 피질의 본질적인 성질을 무시하고 간단한 문제들을 성공적으로 해결하는 간단한 모델을 추구했다고 말했다. 하지만 이미 지난 2016년 인간을 이기는 바둑 천재 AI 머신 ‘알파고’가 등장해 이러한 예측들은 빗나가고 말았다.

세계는 이미 4차 산업혁명에 진입했으며 인공지능은 빠르게 인간을 대체해 나갈 것이다. 또 널리 퍼져 있지 않을 뿐 미래는 이미 와 있으며 인공지능, IoT, 클라우드 컴퓨팅, 빅데이터 등이 융합되면서 4차 산업혁명이 발생하고 있다. 과거 산업혁명이 ‘기계근육’을 만드는 과정이었다면 4차 혁명에서는 ‘기계두뇌’가 탄생할 것이다. ◆

(참고자료)

“인공지능(AI)은 어떻게 발달해왔는가, 인공지능의 역사”, kor nvidia, 2016.03

“위키피디아”